生成AIの代表であるChatGPTは、近年は仕事だけでなくプライベートでも活用する機会が増えています。

しかし、ChatGPTには情報漏えいのリスクもあるため、セキュリティ対策や安全なAI活用方法を理解しておかなければなりません。

本記事では、ChatGPTの情報漏えいリスクについて詳しく解説します。

ChatGPTの情報漏えい被害事例からセキュリティ対策、安全にAIを活用する方法まで詳しく解説するので、ぜひ最後までご覧ください。

目次

ChatGPTの普及と現状

ChatGPTは2022年11月にGPT-3.5が登場したことにより、幅広いユーザーに認知されました。

ChatGPTのリリース時期は、下記のとおりです。

|

モデル |

リリース時期 |

|

GPT-1 |

2018年 |

|

GPT-2 |

2019年 |

|

GPT-3 |

2020年 |

|

GPT-3.5(ChatGPT) |

2022年11月 |

|

GPT-4 |

2023年3月 |

|

GPT-4o |

2024年5月 |

|

GPT-4.1 |

2025年4月 |

|

o3 |

2025年4月 |

|

o4-mini |

2025年4月 |

|

GPT-5 |

2025年8月 |

GPT-3.5のリリースにより爆発的に普及していったChatGPTは、2025年8月にGPT-5まで進化しました。

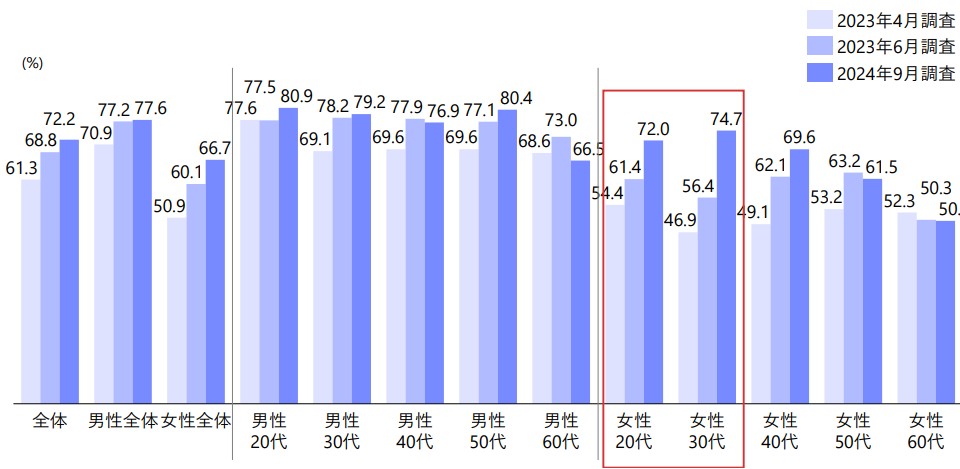

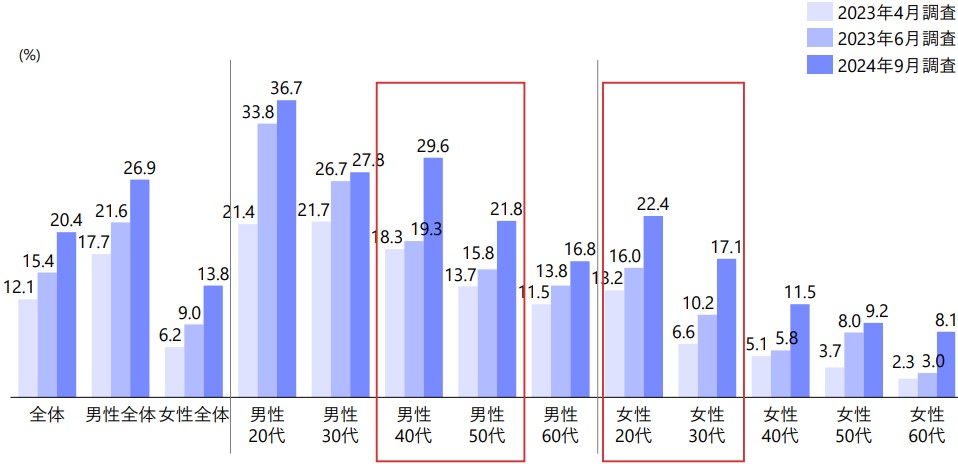

野村総合研究所が実施した調査によると、2024年9月時点でChatGPTの認知率は72.2%、利用率は20.4%まで普及しています。

▼ChatGPTの性年代別認知率の変化

▼ChatGPTの性年代別利用率の変化

引用元:野村総合研究所|日本ChatGPT利用動向(2024年9月時点)

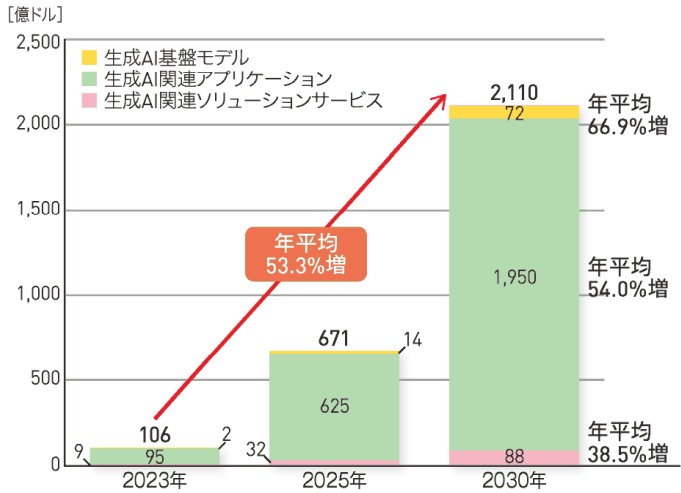

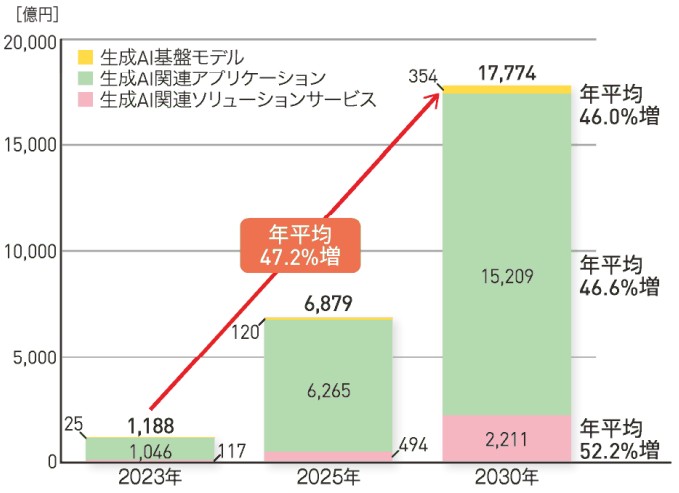

一般社団法人電子情報技術産業協会が発表した資料によると、生成AI市場の需要額は世界規模では年平均53.3%増、日本規模では年平均47.2%増と拡大する予測です。

▼生成AI市場の需要額見通し(世界)

▼生成AI市場の需要額見通し(日本)

引用元:一般社団法人電子情報技術産業協会|JEITA、生成 AI 市場の世界需要額見通しを発表

今後もChatGPTの需要は拡大し、普及率が増加する予測です。

ChatGPTの概要

ChatGPTは、OpenAIが開発した大規模言語モデル(Large Language Model:LLM)ベースのチャットAIです。

人間が自然言語で投げかける問いかけに対し、文章生成・対話・要約・翻訳・校正、さらには簡易的なプログラムコードの作成など、多様な用途で応答できます。

2022年11月のGPT-3.5リリース以来、高い対話能力や柔軟性が評価され、教育、業務効率化、クリエイティブ制作など幅広い分野で活用が広がりました。

日本国内でも、認知率・利用率ともに年々上昇しており、「AIツール」の代表例としてのポジションを確立しています。

ChatGPTのビジネス活用例

ChatGPTは、さまざまなビジネスシーンで活用されています。

例えば、下記のような事務作業・カスタマーサポートなどで、生成AIを活用することで業務効率化を実現しています。

- 業務メールや報告書の文章校正

- 企画書やプロポーザルのドラフト作成

- FAQやマニュアルの作成支援

- 画像・動画作成

- Excelの関数作成

- プログラミングコード作成支援

- データ分析・レポート作成

- 意思決定支援・戦略立案

AIとサイバー攻撃の進化

AI技術の進歩は、サイバー攻撃者側にも技術的な進化をもたらしています。

最近では、AIを活用したマルウェアや自動化されたフィッシング攻撃、ネットワークトラフィックを分析して脆弱性をつく攻撃などが報告されており、サイバー攻撃のスピード・精度・適応性が向上しています。

AIによる異常検知の回避や、生成AIを使った検証可能性の低い偽情報の生成などは、企業や組織のセキュリティ対策担当者に大きな課題となるリスクです。

サイバー攻撃もAIによって進化している現代において、AIを利用する側にもリスクアセスメントや安全なガバナンス体制を設け、情報漏えいなどの被害を最小化する対策が必要です。

ChatGPTによる情報漏えいリスク

ChatGPTのような生成AIはビジネスや日常生活で便利なツールですが、機密情報や個人情報が漏れてしまう可能性があります。

どのような情報がどの段階で危険にさらされるのか、どのようなメカニズムで漏えいが起きるかを把握しておかないと、個人情報や機密情報が漏えいするリスクがあるため要注意です。

ChatGPTによる情報漏えいのリスクは、大きく分けて下記の3種類です。

- プロンプト情報の漏えいリスク

- アカウント情報の流出リスク

- チャット履歴の流出リスク

それぞれのリスクを確認して、ChatGPTから情報が漏えいしないよう対処しましょう。

プロンプト情報の漏えいリスク

ChatGPT内で指示を出したプロンプトから、情報漏えいするリスクがあります。

プロンプトとは、ユーザーがChatGPTに入力する指示や質問のことです。プロンプト内に企業の内部データ・技術仕様・契約書など機密情報の一部を含めてしまうと、保存環境やキャッシュの影響で、予期せぬ形で他のリクエストに反映される可能性があります。

学術研究でも「ChatGPT4および4oではプロンプトインジェクション攻撃によりユーザーの個人データが抽出される」と報告されており、ユーザーが保存したプロンプト内容を他者に漏らしてしまうリスクも指摘されているのです。

また、AIモデルが以前の入力や指示を高速に処理するため保存するプロンプトキャッシュによって、過去に指示したプロンプトの内容がChatGPT内に保存されている場合、タイミング攻撃などによって情報が漏えいするリスクもあります。

アカウント情報の流出リスク

ChatGPTのアカウント自体が流出すると、他人が不正アクセスすることで、メールアドレス・パスワード・認証情報などの個人情報が漏えいしてしまいます。

過去には、有料ChatGPTユーザーの認証情報が何万件もダークウェブで出回った被害事例があり、アカウント情報の流出には注意しなければなりません。

また、外部サービスとの連携を許可していた場合、連携機能が悪用されるとアカウントを通じたさらなる個人データ・機密データの漏出につながるリスクがあります。

APIやプラグインのセキュリティ設定が甘いと、そこからサイバー攻撃の侵入口となるリスクもあるため、徹底したセキュリティ対策が必要です。

チャット履歴の流出リスク

ChatGPTでの会話内容には、個人の意図や企業の内部情報などが含まれる可能性があります。

チャット履歴が適切に保管・管理されていなかったり、サーバ側でのアクセス制御が不十分であったりすると、情報漏えいのリスクが高まります。

例えば、ユーザーとAI間のチャットを意図的にプロンプトを通じて引き出せる研究結果が報告されています。

チャット履歴が外部からアクセス可能な状態になっている場合や、誤って公開されてしまうと、情報漏えいのリスクが高まるため、適切に管理しておきましょう。

ChatGPTによる情報漏えい被害事例

ChatGPTによる情報漏えいを対策するために、下記の被害事例を確認しておきましょう。

- 企業の機密情報が外部に漏えいした事例

- バグによりチャット履歴が漏えいした事例

- アカウント情報がダークウェブで流出した事例

企業の機密情報が外部に漏えいした事例

大手企業で、ChatGPTに社内プロジェクトの設計仕様やソースコードなどの機密情報を入力してしまい、その情報が外部に漏れてしまった事例があります。

具体的には、利用者が内部文書の要約や説明をAIに頼む際に、内容に機密技術情報が含まれていたにもかかわらず、削除・匿名化を行わずに入力してしまいました。

結果として、入力内容が何らかの形でモデルのキャッシュや第三者のアクセス可能な部分に残り、外部に流出する可能性が指摘されました。

この被害事例は、誤操作や利用ガイドラインの不備が原因のため、ChatGPTの操作マニュアルや利用ガイドラインの整備が必要です。

バグによりチャット履歴が漏えいした事例

2023年に一部のChatGPT利用ユーザーが、自分以外の利用者のチャット履歴タイトルや一部の内容を閲覧できてしまうバグが発生しました。

具体的には、セッション間の識別が適切に分離されておらず、あるユーザーがログイン中に別ユーザーのチャット一覧タイトル・開始メッセージの一部が見える状態になっていたリスクです。

さらに、メールアドレス・カードの種類・カード番号下4桁・有効期限などの支払い情報が、特定の期間にわたって漏えいした可能性があり、サービス提供者がバグを認めて謝罪し、問題の修正を行った事例が確認されています。

アカウント情報がダークウェブで流出した事例

複数のユーザーアカウント情報(メールアドレスやパスワードなど)が、悪意あるマルウェア感染やフィッシング攻撃によって盗まれ、ダークウェブ上で取引されていた事例が報告されています。

例えば、日本国内で約600件以上のChatGPTアカウントが流出・売買対象となった事例があり、ChatGPTを活用する際にセキュリティ対策が重要視されました。

アカウント情報がダークウェブで流出した背景には、ユーザーが脆弱なパスワードを使っていたり、多要素認証無しで利用していたりしたことが原因として挙げられています。

ChatGPTの情報漏えいを防ぐセキュリティ対策

ChatGPTの情報漏えいを防ぐために、下記のセキュリティ対策を実施しましょう。

- 機密情報を入力しない

- 利用ルールを策定する

- 従業員のセキュリティ意識を高める

- オプトアウトする

- API連携でセキュリティ性を強化する

- ChatGPT Enterpriseを利用する

- DLPを導入する

機密情報を入力しない

ChatGPTの情報漏えいを防ぐ効果的な対策は、機密情報を入力しないことです。

具体的には、下記のように外部へ漏えいしてはならない情報を入力しないよう注意しましょう。

- お客さまデータ

- 取引先名

- 契約内容

- ソースコード

- 社内プロジェクト情報

入力データがモデル学習やログに残るリスクがあるため、ChatGPTに入力する情報は、公開されても問題ないものに限定しましょう。

利用ルールを策定する

企業でChatGPTを導入する際には、利用ルールの整備が不可欠です。

具体的には、下記のようにChatGPTを利用する際のルールを規定し、従業員全体に周知しましょう。

- 入力禁止情報の定義

- 利用目的の範囲

- 管理者による利用状況モニタリング

上記のような利用ルールを策定すれば、セキュリティリスクのある入力を未然に防ぎ、利用者の判断基準を統一できます。

従業員のセキュリティ意識を高める

ChatGPTの利用ルールを整備しても、利用者が守らなければセキュリティを高められません。

ChatGPTの情報漏えいを防ぐには、従業員教育を通じたセキュリティ意識向上が必要です。

定期的な研修やワークショップを行い、情報漏えいの事例や被害の深刻さを共有することで、日常的にリスクを意識してもらいましょう。

オプトアウトする

OpenAIのChatGPTには「Chat History&Training」機能があり、これをオフにすることで入力履歴を学習に利用させないよう設定できます。

履歴を残さないよう設定することで、機密情報が誤ってモデルの学習データに含まれるリスクを軽減できます。

情報の二次活用を防ぐ「オプトアウト」の設定を徹底すれば、ChatGPTによる情報漏えいを防げるため安心です。

API連携でセキュリティ性を強化する

ChatGPTを業務システムと統合する場合、APIを利用した連携が有効です。

API利用では、データの保存や管理範囲を制御できるため、Web版のChatGPTよりもセキュリティを担保しやすいです。

また、API連携によって既存のアプリケーションに生成AIの機能を組みこむことで、業務効率化・お客さま満足度の向上にもつながります。

ChatGPT Enterpriseを利用する

OpenAIが提供するChatGPT Enterpriseは、セキュリティ・プライバシー保護が強化された法人向けサービスです。

Enterprise版では、入力データが学習に利用されず、データは暗号化されて安全に処理されます。

またChatGPT Enterpriseを利用すると、情報漏えいリスクを低減できるだけでなく、データ分析機能やカスタマイズ機能などの機能を活用できます。

大規模企業や情報管理に厳しい業種では、通常版ではなくEnterpriseへのアップグレードを検討しましょう。

DLPを導入する

DLP(Data Loss Prevention)ツールの導入も有効です。

DLPは、ユーザーが外部サービスに機密情報を入力しようとした際に検知・ブロックできる仕組みを持っています。

お客さま情報や機密情報が含まれるプロンプトを送信する前に、自動的に検知して通知またはブロックしてくれるため、ChatGPTによる情報漏えいを防げます。

ChatGPT利用時における情報漏えいリスクをシステム的に抑止できるため、組織的なセキュリティ対策として有効です。

ChatGPTで起こりえる情報漏えい以外のAI活用リスク

ChatGPTは、強力なAIツールとしてさまざまな業務での活用が進んでいますが、情報漏えいだけでなく、誤情報生成・著作権問題・悪用リスクなど、他のリスクも無視できません。

ChatGPTで起こりえる次のリスクを確認して、情報漏えい以外のセキュリティ対策を徹底しましょう。

- ハルシネーション

- 著作権・知的財産権の侵害

- サイバー攻撃への悪用

ハルシネーション

ハルシネーションとは、ChatGPTなどの生成AIが、質問内容に対して「もっともらしいが誤った回答」を生成してしまう現象を指します。

例えば、存在しない事実を元にしたデータや引用を提示したり、誤った統計値を返したりするケースがあります。

ドキュメントや報告資料・法的文書などでハルシネーションが混じると、誤解を招いたり信頼性を失ったり、最悪の場合は法的責任につながる可能性もあります。

生成AIは学習データのバイアスや欠落、学習中の過剰一般化などによってハルシネーションが発生するため、利用時にはソースの裏付けを取りましょう。

著作権・知的財産権の侵害

ChatGPTのような生成AIは、膨大な既存データやインターネット上の文章を基に回答するため、著作権保護されたコンテンツを許可なく使用したり、出力が既存の著作物と類似したりと著作権を侵害するケースがあります。

近年では、著作者がAIモデルの訓練データとして自分の作品が無断で使われたと主張する訴訟が増えており、出力内容が他人の文章や図表、画像と近似した場合、法的な紛争に発展するリスクがあります。

また、生成されたコンテンツを二次利用する際、著作権の有無を検証していないと、意図せず侵害リスクを抱えるため要注意です。

サイバー攻撃への悪用

生成AIの能力は利便性だけではなく、悪意ある目的に使われるリスクもあります。

具体的には、フィッシングメールや詐欺メールの作成、ソーシャルエンジニアリング攻撃における文案作成支援、偽レビューや偽情報の大量生成などに注意が必要です。

AIが作成するコンテンツは巧妙で説得力があるため、受け手側が偽物と気づきにくい特性があります。

さらに、悪意あるユーザーがプロンプト操作や入力インジェクションを用いて意図しない出力を引き出すケースも報告されており、システムやアプリケーションレベルでサイバー攻撃への対策が求められています。

ChatGPTで情報漏えいを防ぐためにセキュリティ対策を徹底しよう!

ChatGPTで情報漏えいを防ぐためには、従業員教育をはじめとするセキュリティ対策が欠かせません。

個人情報や機密情報の漏えいを防ぐために、ChatGPTの利用マニュアルを策定し、組織内で利用方法を周知することが大切です。

ChatGPTの利用マニュアルは、情報漏えいを含むセキュリティリスクに対処できるよう想定されるリスクとサイバー攻撃の脅威を確認しておきましょう。

下記では、情報セキュリティ担当者向けに、セキュリティ対策のポイントを解説しているため、ChatGPTの利用マニュアルを策定する際の参考にしてください。

おすすめのお役立ち資料はこちら↓